tmarketingvn

Thành viên

- Tham gia

- 3/3/2022

- Bài viết

- 2

Crawl là gì?

Crawl là một thuật ngữ chỉ quá trình tự động truy cập website và lấy dữ liệu thông qua một chương trình phần mềm trên website, tiến hành phân tích mã nguồn HTML để đọc dữ liệu và lọc ra theo yêu cầu người dùng hoặc dữ liệu mà Search Engine yêu cầu nhờ thông qua các bot (robot).

Dễ hiểu hơn, Crawl là kỹ thuật mà các con robot của: Google, Bing Yahoo,… các trang thương mại điện tử (Amazon, Lazada, Shopee,…) hay nền tảng bán chuyên POD (Teechip,…),… sử dụng.

Web Crawler là gì?

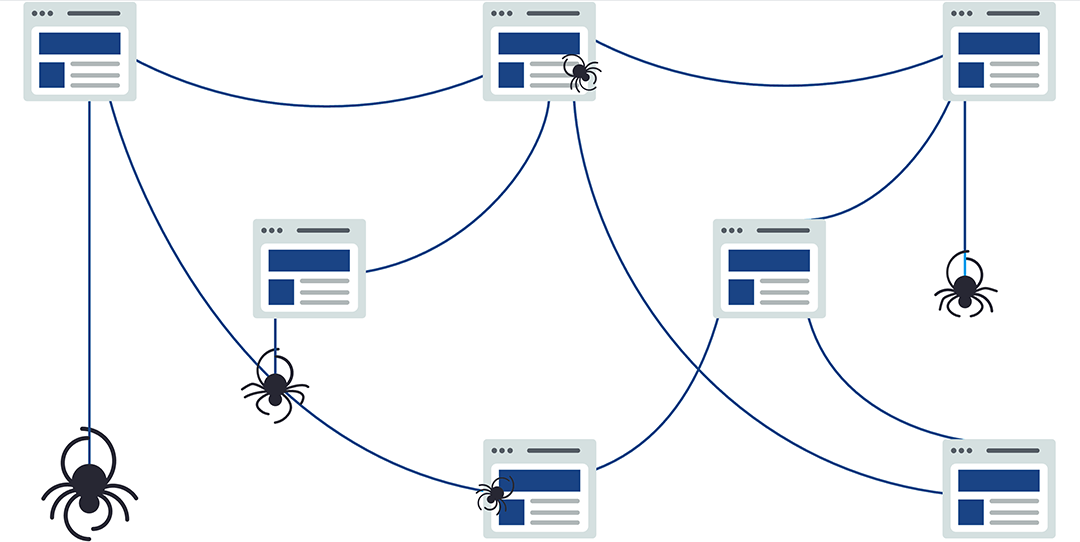

Như định nghĩa ở trên thì Web Crawler là một web thu thập thông tin, đôi khi được gọi là spider hoặc spiderbot. Thường sẽ được gọi rút ngắn thành crawl, là một bot Internet duyệt web một cách có hệ thống trên World Wide Web, có nhiệm vụ tải xuống và Index toàn bộ phần content từ khắp các nơi trên Internet.Web Crawler bắt đầu với một danh sách các URL cần truy cập. Khi Web Crawler truy cập các URL này, chúng sẽ lần lượt truy cập vào từng liên kết trên trang mà nó bắt gặp và thêm chúng vào danh sách các URL cần truy cập rồi tiếp tục thu thập dữ liệu ở các URL mới đó. Dữ liệu thu thập được trong từng lần crawl sẽ được gửi về máy chủ tìm kiếm kèm theo thời gian hoàn tất crawl trước đó để được Search Engine (công cụ tìm kiếm) là phần mềm được truy cập trên Internet để tìm kiếm cơ sở dữ liệu thông tin theo truy vấn của người dùng.

Web Crawler thông qua thuật toán, chúng giúp công cụ tìm kiếm có thể cung cấp các liên kết có liên quan để đáp ứng các nhu cầu tìm kiếm của người dùng. Sau đó, tiếp tục tạo danh sách các trang web cần hiển thị sau khi người dùng nhập từ khóa vào thanh tìm kiếm. Web Crawlers có thể xác thực các siêu liên kết và mã HTML. Chúng cũng có thể được sử dụng để quét web và lập trình theo hướng dữ liệu.

Tại sao web crawlers được gọi là ‘spiders’?

Việc gọi các bot của công cụ tìm kiếm là “spiders” là điều hoàn toàn tự nhiên, bởi vì chúng thu thập dữ liệu từ trang này, kéo sang trang khác nhờ siêu liên kết được đính kèm trong bài, cứ như vậy đường đi cũng web crawlers ngày càng chằng chịt và trải rộng trên khắp các trang web, giống như những con nhện bò giăng tơ từ nhiều điểm nhưng chúng đều có sự liền mạch với nhau.Cách bot công cụ tìm kiếm crawl website

Internet ngày càng phát triển, các website mọc lên như nấm không ngừng và mở rộng. Các crawler website thu thập dữ liệu trên các trang bằng hoạt động đi qua tuần tự các liên kết, gửi dữ liệu đó về cho máy chủ search engine. Quá trình này thường bắt đầu với một danh sách các địa chỉ website nhất định, xong sẽ thu thập qua tất cả các trang có liên quan với nhau, và các liên kết mới luôn được ưu tiên. Quá trình này kết thúc khi đã thu thập xong các thông tin, dữ liệu trang. Các crawler sẽ tổng hợp lại và gửi về ngân hàng dữ liệu chờ để được xét duyệt. Vì vậy, nôm na có thể hiểu rằng: các web crawler như con nhện sẽ phải thu thập từ các từ khóa tìm kiếm phổ biến nhất rồi tạo thành các list theo từng chủ đề đã thu thập được. Tại các URL ban đâu, các con nhện này sẽ tìm ra các siêu liên kết dẫn đến nhiều URL khác, rồi tiếp tục tạo thành các list cần thu thập thông tin tiếp theo,… các vòng như vậy sẽ lặp đi lặp lại không ngừng không có thời hạn.

Tuy nhiên, web crawler sẽ tuân theo một số quy tắc nhất định giúp nó chọn lọc hơn trong việc thu thập dữ liệu, thu thập dữ liệu một cách có trình tự, năng suất hơn.

Revisiting webpages

Nội dung trên web liên tục được cập nhật, xóa hoặc di chuyển đến các vị trí mới nên Web Crawler sẽ cần phải truy cập lại các trang theo định kỳ để đảm bảo rằng sẽ luôn cập nhật phiên bản mới nhất của nội dung được lập danh sach trước đó.Hầu như các web crawler theo quy tắc là chọn những trang sẽ thu thập dữ liệu đầu tiên dựa trên số lượng các trang khác liên kết đến trang đó, lượng truy cập, các yếu tố khác như biểu thị khả năng cung cấp thông tin quan trọng của trang,… Chứ không thu thập vì bất kì lí do chủ đích hay những bài ngẫu nhiên công khai trên internet. Do hoạt động theo cách “giăng tơ” như trên, nếu trang web có lượt truy cập cao sẽ dễ dàng trở thành trang web có thông tin quan trọng, vì vậy, điều đặc biệt quan trọng là công cụ tìm kiếm phải lập list – giống như thư viện có thể làm đảm bảo giữ nhiều bản sao của một cuốn sách được nhiều người xem, các trang này rất dễ được index ngay lập tức.

Liệu có thông tin nào bị bỏ qua không?

Số lượng các trang Internet là vô cùng lớn, ngay cả những Web Crawler lớn nhất cũng không thể hoàn chỉnh. Vì lý do này, các công cụ tìm kiếm đã phải vật lộn để đưa ra các kết quả tìm kiếm có liên quan trong những năm đầu của World Wide Web trước năm 2000. Ngày nay, các kết quả có liên quan được đưa ra gần như ngay lập tức. Do đó, các bot crawl sẽ bắt đầu với các trang web phổ biến trước, rồi mới lần theo các siêu liên kết từ các trang này đến các trang khác và đến cả các trang bổ sung. Một số nguồn ước tính rằng chỉ 40-70%, tương ứng với hàng tỷ website trên Internet được index cho mục tìm kiếm.Để có thể hiểu rõ hơn thì bạn có thể xem tại đây